全新AI:从声音推出长相 细思极恐?

发布者:北京四合院 | 2022-05-11 08:10:15 | 来源:hefei

【星网专讯】

人们听广播的时候,脑海中会幻想出说话者的样貌,

她可能是个面容清秀、身材瘦小的年轻女孩,他也可能是个四十出头、脸长肩宽的中年男人。

猜准年纪和性别,对大部分人来说不难,声音特质已经透露出这些信息。

但猜对具体的容貌却非常困难,人们只能回想脑海里有类似声音的人,把他们的脸贴上去。

人的声音和长相应该是分开的吧……

AI告诉我们:答案不对,有特定声音的人,会有特定的长相。

最近,麻省理工大学的科学家开发出一款AI,它能通过几秒钟的音频,还原出说话者的容貌,相似度非常高。

年龄、性别、种族、五官特征、脸型、发型、胡须造型,这些它能会绘制出来……

这款AI叫作“Speech2Face”,名字说得很清楚,“从话到脸”。

科学家创造它的目的,是想知道人类能在多大程度上,通过一个人的声音推断出他的长相。

乍一听上去,这像看相那样玄学,但背后的道理其实很好理解。

人类说话靠的是振动声带,它是位于喉部的左右对称的两瓣肉。声带的长度和宽度是影响我们音调高或低的主要原因,因为男性的声带较女性更宽,所以音调更低。

声带振动后,声音在我们的胸腔里嗡嗡作响,大部分从喉咙里传出去。

但这不是唯一的传声路径,我们的脸部也充当着声音的扩音器,颧骨、下巴、鼻子、嘴唇等都会振动,它们的厚度、结构不同,发出的声音也不同。

电脑能捕捉到这些细微的声音差别,继而画出说话者的面部特征。

这就是AI工作的原理。

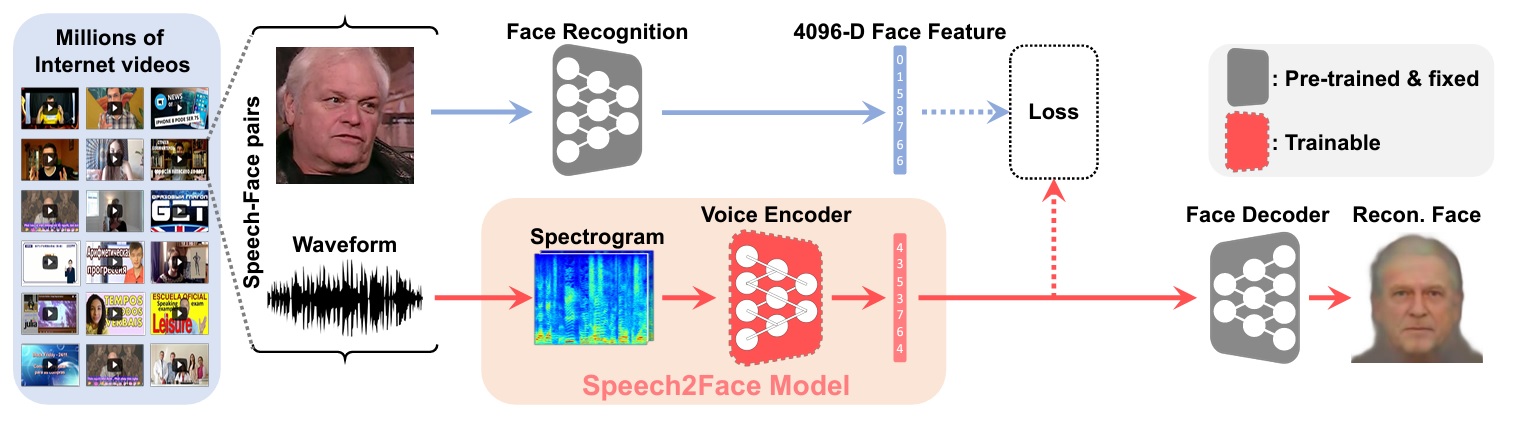

麻省理工的科学家们收集了油管上数百万个视频,里面有十几万个人说话,他们将这些视频输入给Speech2Face。

Speech2Face会把视频中人脸的特征摘出来,制作出一张标准的正面照,这个照片基本等同对方的真人脸。

同时,它还会把声音从声波转成声谱图,然后传给人声编码器,找出其中的声音特征。

两两相对,Speech2Face就这样学会声音和相貌之间的关联,不需要其他的信息。

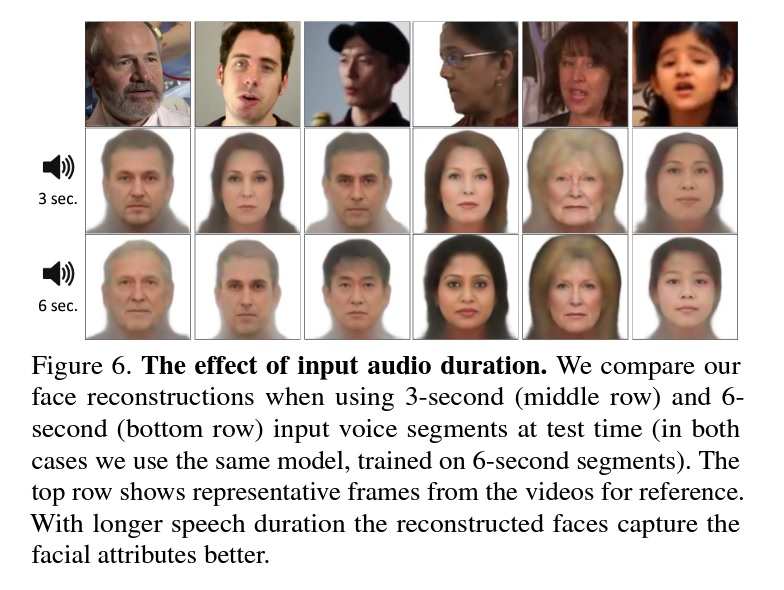

在大量视频的训练下,它只需要听3秒或6秒的音频,就能画出人脸。

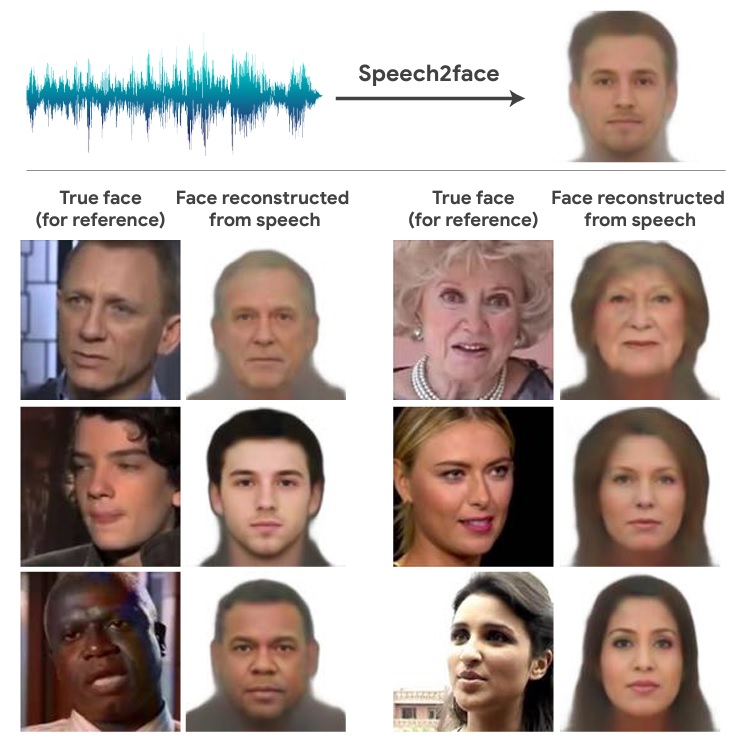

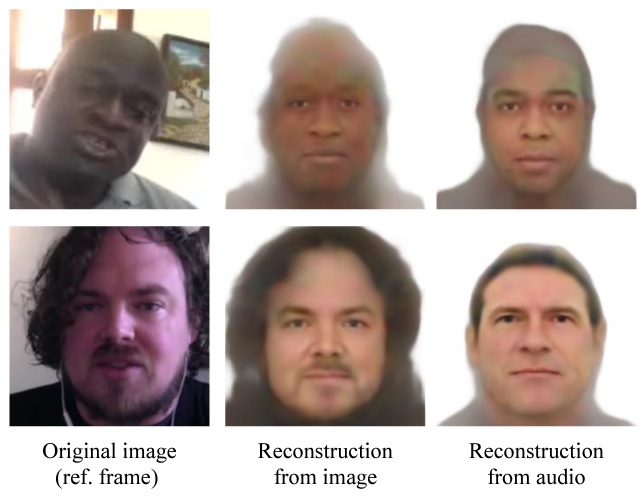

比如,放美国情景喜剧《神烦警探》中男二霍尔特讲笑话的音频片段,Speech2Face会画出下方右侧的图。

和饰演霍尔特的演员相比,右侧的图脸更宽和胖,但肤色和鼻子形状与真人一样,效果不错。

其他测试对象还有白人老太太、非裔男子、拉美女孩和白人男性,

左边的真人图和右边的AI图对比,都挺像。

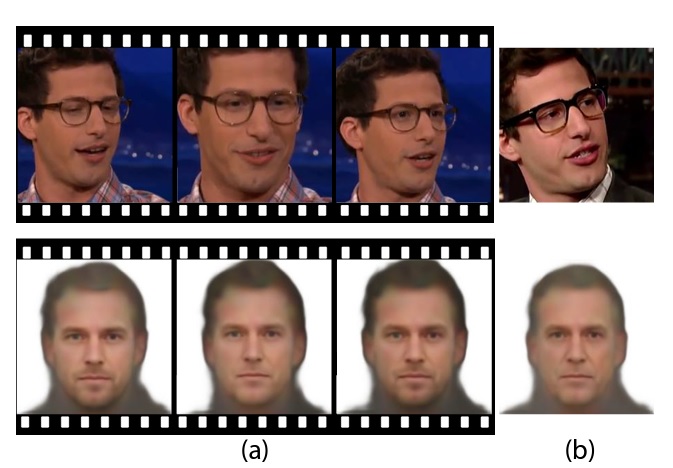

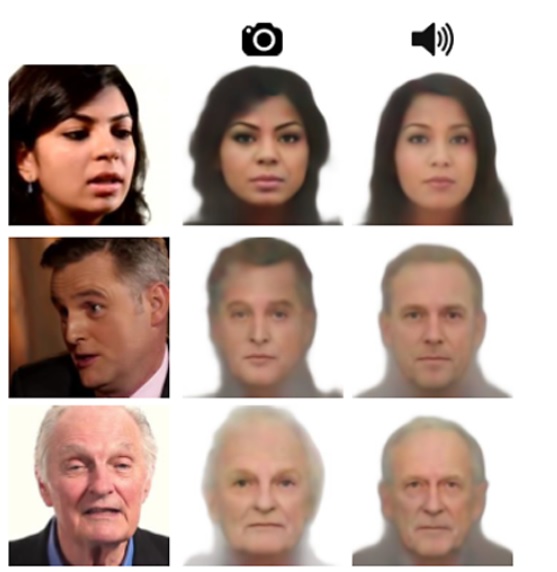

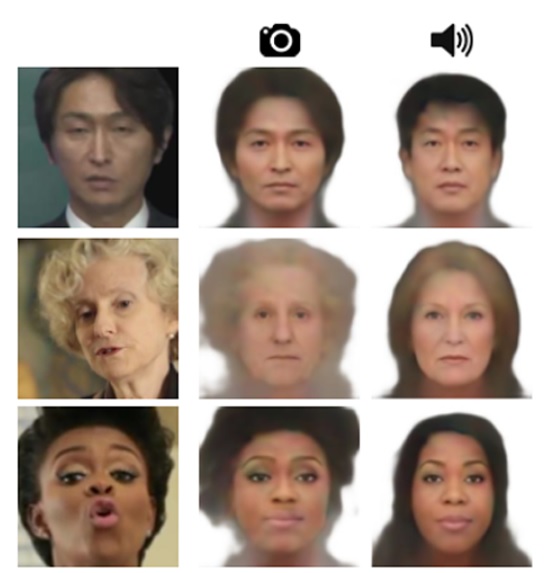

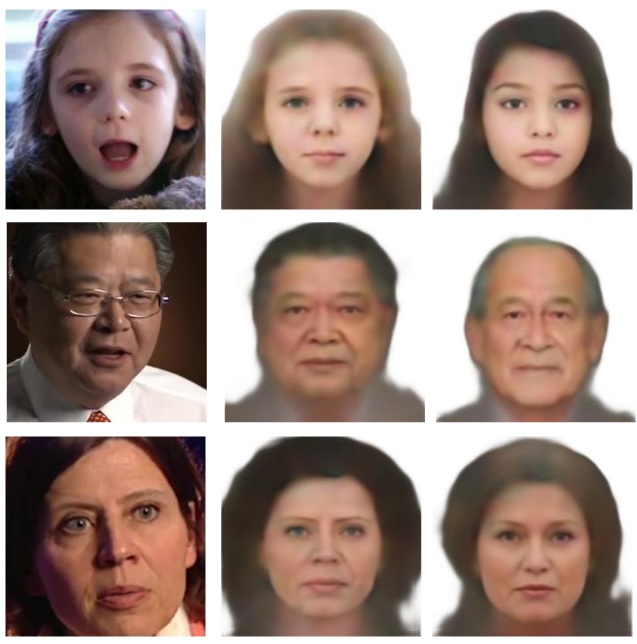

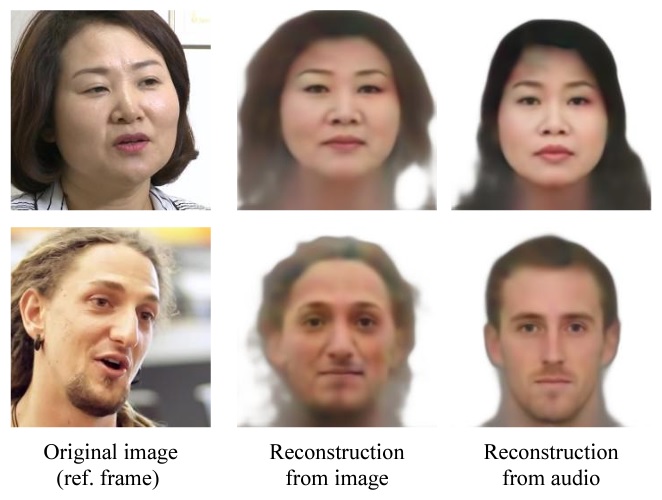

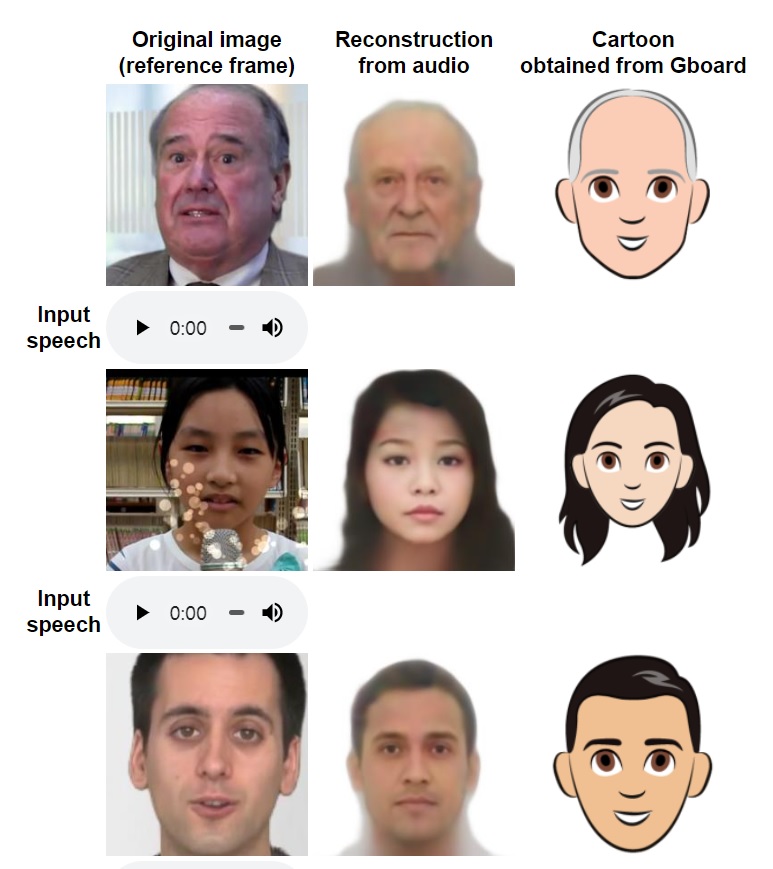

类似的对比图在论文里还有很多,下面这些图的第一列是视频截图,第二列是电脑根据截图转换的正面照,第三列是AI根据声音绘制的图。

将第三列和前两列对比,发现种族、性别、年龄、眉毛、发型和发色基本都对。

为什么眉毛和头发也能相似?它们又不随声音振动。

科学家解释说,是因为AI在数百万视频中找到同一类人群相似的外形特征。比如非裔女性常是高挑眉,老年人永远头发稀疏,印裔男子喜欢留胡子,非洲男性戴顶小帽子。

在性别、种族特征符合后,这些边缘的外貌特征也会被画出来。

科学家们发现输入的音频越长,AI绘制的图越准确。下图可以看出,六秒音频的结果明显比三秒要好,其中有三个改对了性别、种族和年龄。

如果把一个人的不同视频片段截出来,会发现它们和AI绘制的图更像。

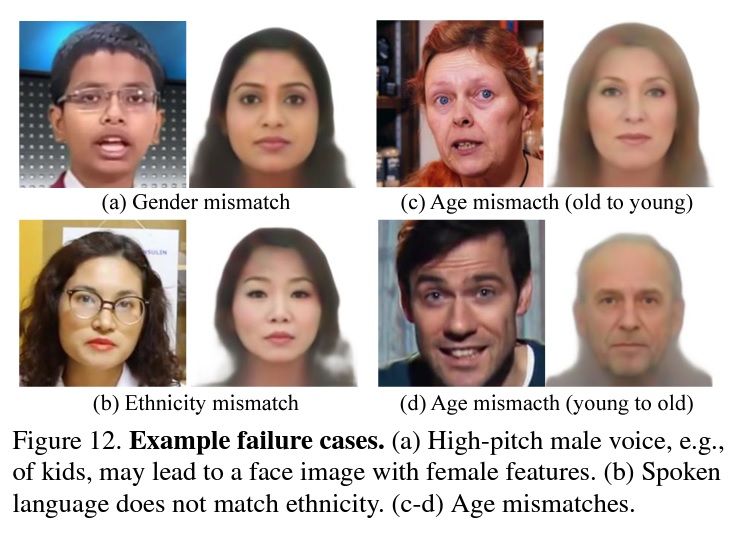

当然,Speech2Face也有翻车的时候,它有时会把音调高的男人当作女人,把声音嘶哑的男人当作老头。

种族也会搞错(虽然长得仍然挺像)。

科学家说这更多表现出的是一种刻板印象,AI能找到的是符合大部分人群的特征。

“我们使用的训练数据来自油管上的教育视频合集,不能代表全世界的人。” 他们在论文里写道,“因此,就像其他机器学习模型一样,我们的模型也受到数据分布不均的影响。”

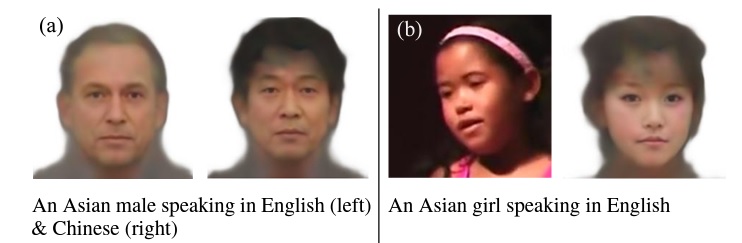

这种刻板印象也和语言有关,当亚裔男性说英语时,Speech2Face以为他是白人男性,当他说中文时,种族又对了。

不过,亚裔女孩说英语时,结果不受语言影响,只是年龄大了些。

麻省理工的科学家们还做了一个“卡通转换系统”,让Speech2Face听到音频后绘制出说话者的卡通图,准确率也挺高的。

这个项目挺有意思,但很多网友表示担忧:

“那些不愿露脸的油管博主现在肯定在瑟瑟发抖。”

“想想看,这技术很容易在网络社区里被当作武器使,虽然大家都不露面。”

科学家们在论文里也提到了隐私,他们认为不用担心。

“我们的方法不能从声音中复原一个人的真实身份(即他们脸部的确切图像),因为我们的模型是捕捉多人共有的视觉特征,只能生产大众化的平庸面孔,不能制作特定长相。我们的AI图像不能反映出真人的实际相貌。”

话是这么说,可从对比图上看,AI的结果已经很接近真人照了。

如果某些狂热粉丝想要找到不露面的视频博主,他们可以轻松知道博主的大概样子,加上地理位置等信息,也许他们能找上门。

想想还是蛮吓人的,不过类似的AI就算麻省理工不做,其他学校也在做了。

过去几年,爱尔兰、西班牙、日本和美国都在研究如何用音频构建人脸,其中走得最远的是卡内基梅隆大学的丽塔·辛格(Rita Singh)。

有好事者在2014年反复向美国海岸警卫队报假警,每通电话非常短。海岸警卫队找到研究语音识别20年的丽塔,问她有什么办法。

她先是比较了人耳无法察觉的发音上的特征,然后把报警电话分割为几毫秒的小片段,用AI梳理它们寻找信息点。

靠着微弱的信息,丽塔不光能知道报假警的人大致长什么样,还能知道他所处的环境,比如房间的大小,是否有窗户,以及墙壁用什么材料制成。

她的AI甚至能检测到录音中,因为当地电网波动产生的杂音。她将杂音和电网数据库匹配,可以知道报警者实际的位置,还有挂电话的确切时间。

最后,丽塔不仅解决了恶作剧电话,还解决了儿童性骚扰案件。

那些只露声不露脸的罪犯,自己把自己出卖了。

AI技术就是一把双刃剑,它可以逮捕罪犯,也可以伤害无辜者。

用声音绘制人脸,这个技术看来是无法避免的,只能希望它以后都用在正道上吧……